簡易安裝本地端AI系統

我是點哥

先決條件

在開始之前,請確保您具備以下條件:

一台具有足夠記憶體和儲存空間的電腦(建議至少 8GB RAM;若使用較大型號如 Gemma 3 27B 或 DeepSeek-R1 70B,則需要更多)。

網路連線以進行初始下載。

一個現代網頁瀏覽器(例如 Google Chrome)以安裝和使用 Page Assist。

步驟 1:安裝 Ollama

Ollama 是一個允許您在本地運行大型語言模型的工具。請按照以下步驟進行安裝:

下載 Ollama:

訪問官方 Ollama 網站:https://ollama.com/

前往「下載」部分。

選擇您的作業系統(macOS、Linux 或 Windows)並下載安裝程式。

安裝 Ollama:

macOS:打開下載的 .dmg 檔案,將 Ollama 應用程式拖到您的「應用程式」資料夾中。

Linux:在終端機中運行提供的安裝腳本:

curl -fsSL https://ollama.com/install.sh | sh

Windows:運行 .exe 安裝程式並按照螢幕上的指示操作。

驗證安裝:

打開終端機(或 Windows 上的命令提示字元)。

運行以下命令檢查版本:

ollama --version

如果安裝成功,您將看到版本號(例如 0.1.26 或更高版本)。

步驟 2:下載 DeepSeek 和 Google Gemma 3 模型

安裝 Ollama 後,您可以下載 DeepSeek-R1 和 Gemma 3 模型以在本地運行。

打開終端機並根據您想要的模型大小執行以下命令:

DeepSeek-R1

DeepSeek-R1 有不同的大小(例如 1.5B、7B、14B、32B、70B)。較小的模型需要較少記憶體且速度更快,而較大的模型性能更佳。根據您的硬體選擇:

1.5B 參數:

ollama pull deepseek-r1:1.5b

7B 參數:

ollama pull deepseek-r1:7b

14B 參數:

ollama pull deepseek-r1:14b

32B 參數(需要約 35GB RAM):

ollama pull deepseek-r1:32b

70B 參數(需要大量資源):

ollama pull deepseek-r1:70b

Google Gemma 3

Gemma 3 也有多種大小(1B、4B、12B、27B),較大型號具有多模態功能。選擇一個:

1B 參數(僅文字):

ollama pull gemma3:1b

4B 參數:

ollama pull gemma3:4b

12B 參數:

ollama pull gemma3:12b

27B 參數(多模態,需要大量資源):

ollama pull gemma3:27b

驗證下載:

下載完成後,列出可用模型以確認:

ollama list

您應該會看到如 deepseek-r1:7b 和 gemma3:12b 的條目。

測試模型(可選):

在終端機中直接運行模型以確保其正常運作:

ollama run deepseek-r1:7b

輸入提示(例如「你好,你好嗎?」)並按 Enter 鍵查看回應。

對 Gemma 3 重複操作:

ollama run gemma3:4b

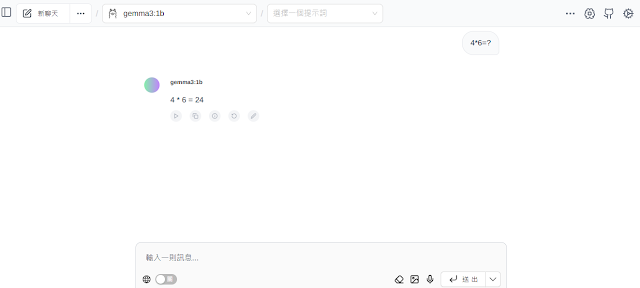

步驟 3:安裝 Page Assist

Page Assist 是一個 Chrome 擴充功能,為本地 AI 模型提供友好的網頁介面。

將 Page Assist 添加到 Chrome:

打開 Google Chrome,前往: https://chromewebstore.google.com/detail/page-assist-a-web-ui-for/jfgfiigpkhlkbnfnbobbkinehhfdhndo

點擊 加入 Chrome,並在確認時選擇 新增擴充功能。

驗證安裝:

安裝完成後,您將在 Chrome 工具列中看到 Page Assist 圖示(一個小的 AI 符號)。

點擊圖示以打開側邊欄或訪問簡易網頁介面。

步驟 4:配置 Page Assist 與 Ollama

Page Assist 需要連接到您本地運行的 Ollama 伺服器以使用 DeepSeek 和 Gemma 3。

啟動 Ollama 伺服器:

確保 Ollama 在後台運行。在 macOS/Linux 上,安裝後會自動啟動;在 Windows 上,您可能需要從開始選單或終端機手動啟動:

ollama serve

伺服器默認運行在 http://localhost:11434。

設置 Page Assist:

點擊 Chrome 中的 Page Assist 圖示以打開側邊欄。

進入 設定(齒輪圖示)在側邊欄或網頁介面中。

在 提供者 下選擇 Ollama。

將 API 端點 設為 http://localhost:11434(Ollama 默認地址)。

保存設定。

選擇模型:

在 Page Assist 介面中,您會看到可用模型的下拉選單。

選擇您之前下載的 DeepSeek 模型(例如 deepseek-r1:7b)或 Gemma 3 模型(例如 gemma3:4b)。

步驟 5:使用 DeepSeek 和 Gemma 3 與 Page Assist

現在一切設置完成,您可以通過 Page Assist 的直觀介面開始使用這些模型。

與模型聊天:

在 Page Assist 側邊欄或網頁介面中,輸入問題或提示(例如用 DeepSeek 問「用簡單語言解釋量子物理」或用 Gemma 3 27B 問「描述這張圖片」如果您有圖片)。

按 Enter 或點擊發送按鈕以獲得回應。

附加功能:

視覺模型:對於 Gemma 3 27B,通過側邊欄上傳圖片以利用其多模態功能(例如「這張圖片裡有什麼?」)。

與文件聊天:上傳 PDF、CSV、TXT、MD 或 DOCX 檔案以詢問其內容(例如「總結這個 PDF」)。

網路搜尋:在 Page Assist 設定中啟用此選項以增強回應(可選)。

切換模型:

使用下拉選單根據不同任務在 DeepSeek 和 Gemma 3 之間切換(例如 DeepSeek 用於推理,Gemma 3 用於多模態查詢)。

故障排除

Ollama 無回應:確保 Ollama 伺服器正在運行(ollama serve),並檢查 Page Assist 中的端點是否為 http://localhost:11434。

模型下載失敗:檢查網路連線和可用磁碟空間,重試 ollama pull 命令。

性能問題:如果模型運行緩慢,嘗試使用較小型號(例如 DeepSeek-R1 1.5B 或 Gemma 3 1B)或關閉其他占用資源的應用程式。